پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

23,700 تومانشناسه فایل: 9208

- حجم فایل ورد: 903.9KB حجم پیدیاف: 248.5KB

- فرمت: فایل Word قابل ویرایش و پرینت (DOCx)

- تعداد صفحات فارسی: 22 انگلیسی: 13

- دانشگاه:Soft Computing Research Group, Faculty of Computer Science and Information Systems, Universiti Teknologi Malaysia, 81310 UTM Skudai, Johor, Malaysi

- ژورنال: Applied Mathematics and Computation (1)

مقدمه مقاله

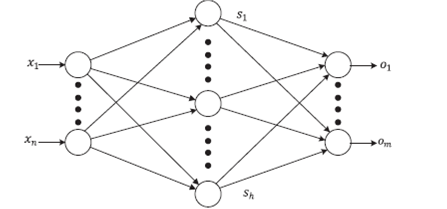

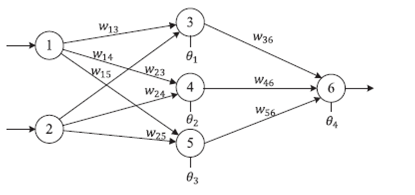

اخیرا ، شبکه های عصبی پیش نگر (FNN ها)، مخصوصا FNN ها با دو لایه ، به طور گسترده مورد استفاده قرار گرفته است در واقع ، FNN ها با دو لایه رایج ترین شبکه های عصبی در کاربرد های عملی هستند. عموما ، یک FNN با دو لایه برای طبقه بندی الگو هایی که به طور غیر خطی قابل تفکیک هستند و همچنین کاربرد های تخمینی، مناسب است. ثابت شده است که FNN های دو لایه ای میتواند تقریبا هر تابع پیوسته و یا غیر پیوسته را تخمین بزند. یادگیری یک بخش بسیار مهم از هر شبکه عصبی است و برای بسیاری از محقق ها این بخش بسیار جذاب است. برای FNN ها ، اکثر کاربرد ها از الگوریتم های انتشار بازگشتی (BP) استاندارد و یا بهبود یافته ، به عنوان روش پرورش شبکه استفاده میکنند. الگوریتم های BP یک الگوریتم مبتنی بر گرادیان است که چندین مشکل دارد ، مانند همگرایی آرام و همچنین گیر کردن در حالت بهینه ی موضعی.

در FNN ها ، در طول روند یادگیری ، هدف یافتن بهترین ترکیب از وزن های ارتباط ها و بایاس ها است تا بتوان به حد اقل خطا دست پیدا کرد. اما ، در بیشتر مواقع FNN ها به نقطه ای همگرا میشوند که از نظر موضعی بهترین راه حل هستند اما در نگاهی کلی ، راه حل بهینه نیستند. به بیان دیگر ، الگوریتم های یادگیری موجب میشوند که FNN ها به حالت کمترین مقدار ممکن خطا در حالت موضعی برسند و به حداقل میان در حالت کلی دست پیدا نکنند. بر اساس مرجع 10 ، همگرایی الگوریتم BP بسیار به مقادیر اولیه وزن ها ، بایاس ها و پارامتر های آن وابسته است. این پارامتر ها شامل نرخ یادگیری و اندازه ی حرکت است. در مقالات ، استفاده از روش های بهینه سازی ابتکاری و یا الگوریتم های تکاملی یک راه حل رایج برای بهبود مشکلات الگوریتم های مبتنی بر BP رایج است.

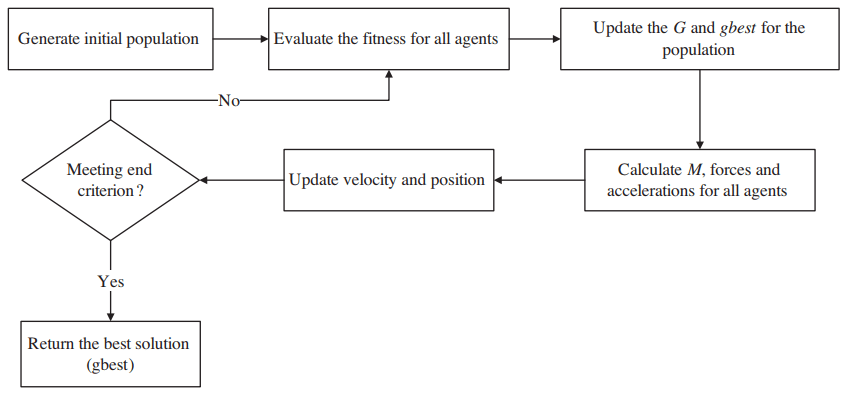

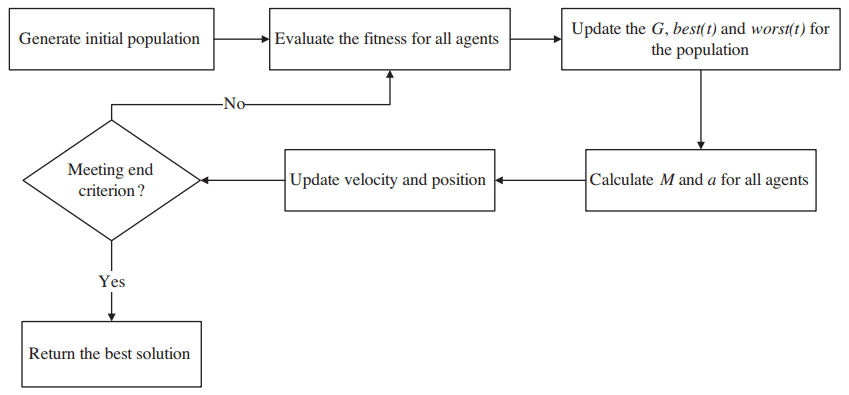

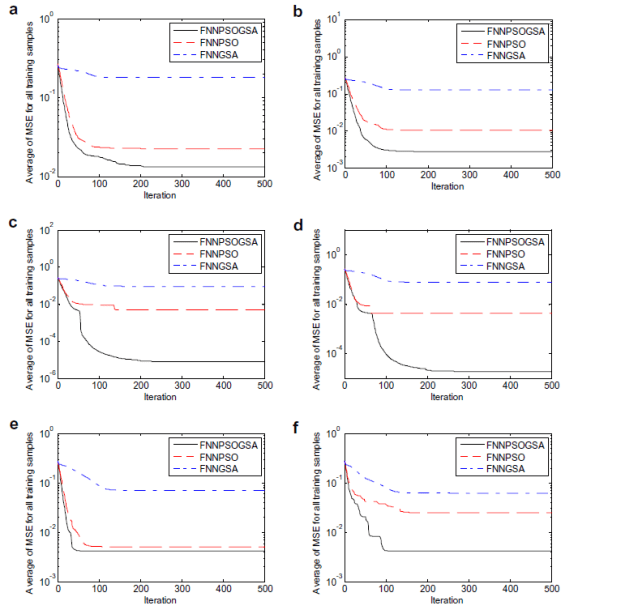

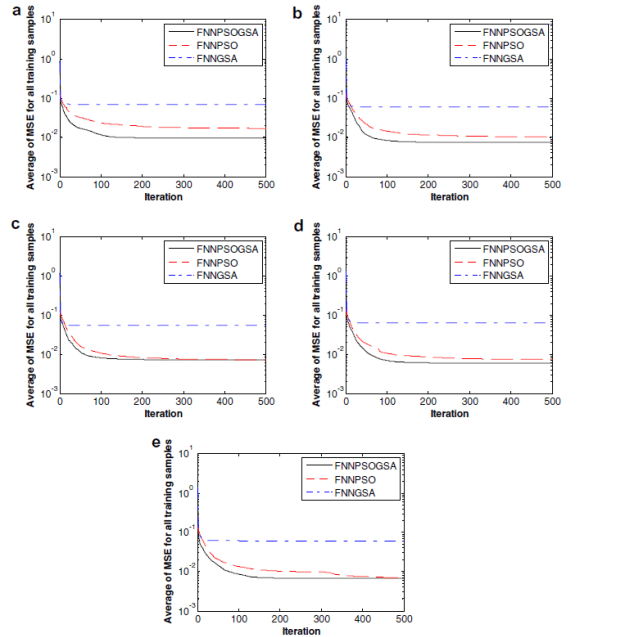

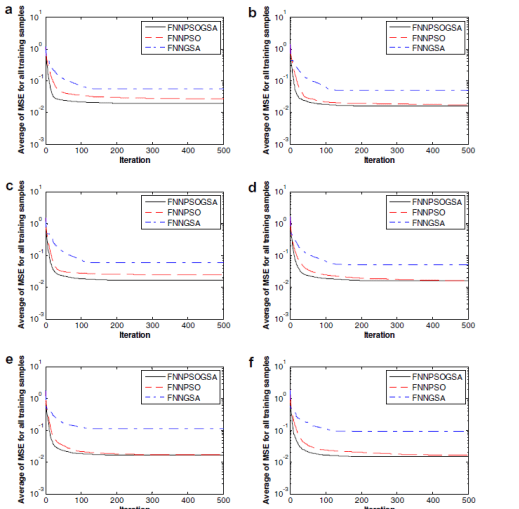

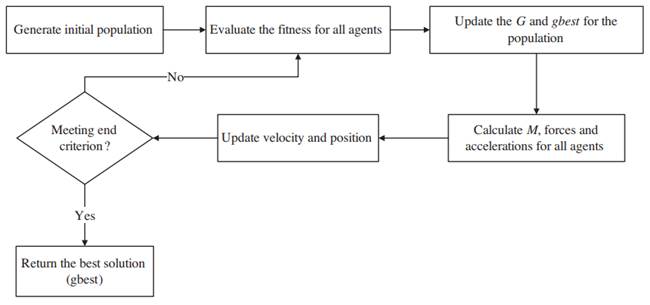

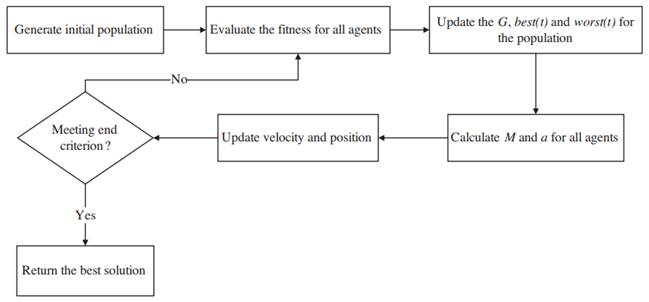

روش های مختلف بهینه سازی ابتکاری متعددی برای پرورش FNN ها مورد استفاده قرار گرفته است ، مانند شبيه سازي تبريد (SA ) ، الگوریتم های ژنتیک ( GA ها ) ، بهینه سازی های ازدحام ذرات (PSO) ، بهینه سازی های مغناطیسی ( MOA ) و تکامل های تفاضلی ( DE ) . بر اساس مرجع 10 ، بعضی از این موارد مانند SA و GA ، میتوانند احتمال رسیدن به حالت بهینه ی موضعی را کاهش دهند ، اما هنوز سرعت همگرایی آن ها پایین است. بر اساس مرجع های 16 و 22 ، PSO یکی از رایج ترین و کار آمد ترین ها و الگوریتم های بهینه سازی ذرات نیز یکی از بهترین ها برای کاهش مشکلات ذکر شده هستند. در این مقاله ، کارایی GSA و PSOGSA ها برای پرورش FNN ها در مقایسه با PSO ، مورد بررسی قرار گرفته است.

بقیه ی مقاله نیز به صورت زیر سازماندهی شده است :

بخش 4-2 مقدمه ی خلاصه از ایده ی PSO ، GSA و PSOGSA را به ترتیب ، ارائه میدهد. بخش 5 روش اعمال PSO ، GSA و PSOGSA را به عنوان الگوریتم های یادگیری تکاملی روی FNN ها مورد بحث قرار میدهد. نتایج آزمایشی نیز در بخش 6 بررسی شده است. نهایتا ، بخش 7 از مقاله ، نتیجه گیری را انجام میدهد.

ABSTRACT Training feedforward neural networks using hybrid particle swarm optimization and gravitational search algorithm

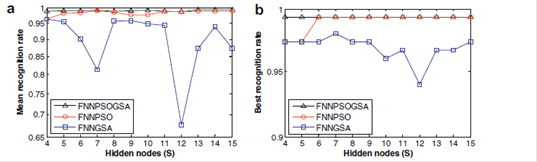

The Gravitational Search Algorithm (GSA) is a novel heuristic optimization method based on the law of gravity and mass interactions. It has been proven that this algorithm has good ability to search for the global optimum, but it suffers from slow searching speed in the last iterations. This work proposes a hybrid of Particle Swarm Optimization (PSO) and GSA to resolve the aforementioned problem. In this paper, GSA and PSOGSA are employed as new training methods for Feedforward Neural Networks (FNNs) in order to investigate the efficiencies of these algorithms in reducing the problems of trapping in local minima and the slow convergence rate of current evolutionary learning algorithms. The results are compared with a standard PSO-based learning algorithm for FNNs. The resulting accuracy of FNNs trained with PSO, GSA, and PSOGSA is also investigated. The experimental results show that PSOGSA outperforms both PSO and GSA for training FNNs in terms of converting speed and avoiding local minima. It is also proven that an FNN trained with PSOGSA has better accuracy than one trained with GSA.

Introduction

Recently, Feedforward Neural Networks (FNNs), especially FNNs with two layers [1], have been widely used. In fact, FNNs with two layers are the most popular neural network in practical applications. Generally, an FNN with two layers is suitable for classifications of nonlinearly separable patterns [2,3] and to approximate functions [4,5]. It has been proven that two layer FNNs can approximate any continuous and discontinuous function [4]. Learning is an essential part of any neural network and becomes attractive to many researchers. For FNNs, most applications have used the standard [6] or improved [7– 9] Back-Propagation (BP) algorithm as their training method. The BP algorithm is a gradient-based algorithm which has some drawbacks, such as slow convergence [10] and the tendency to become trapped in local minima [11].

In FNNs, during the learning process, the goal is to find the best combination of connection weights and biases in order to achieve the minimum error. However, most of the time FNNs converge to points which are the best solution locally but not globally. In other words, learning algorithms lead FNNs to local minima rather than the global minimum. According to [10], the convergence of the BP algorithm is highly dependent on the initial values of weights, biases, and its parameters. These parameters include learning rate and momentum. In the literature, using novel heuristic optimization methods or evolutionary algorithms is a popular solution to enhance the problems of BP-based learning algorithms.

Various heuristic optimization methods have been used to train FNNs, such as Simulated Annealing (SA) [12,13], Genetic Algorithms (GAs) [14], Particle Swarm Optimization (PSO) algorithms [15–19], Magnetic Optimization Algorithm (MOA) [20], and Differential Evolution (DE) [21]. According to [10], some, such as SA and GA, could reduce the probability of trapping in local minima, but they still suffer from slow convergence rates. According to [16,22], PSO is one of the most efficient and practical optimization algorithms in terms of reducing both of the aforementioned drawbacks. In this paper, the efficiencies of GSA and PSOGSA are investigated for training FNNs in comparison with PSO [23]. The rest of the paper is organized as follows: Sections 2–4 present a brief introduction to the concepts of PSO, GSA, and PSOGSA, respectively. Section 5 discusses the method of applying PSO, GSA, and PSOGSA to FNNs as evolutionary training algorithms. The experimental results are demonstrated in Section 6. Finally, Section 7 concludes the paper.

- مقاله درمورد پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- استفاده از بهینه سازی ازدحام ذرات (PSO) هیبرید در پرورش شبکه های عصبی پیشخور (FNN ها)

- پروژه دانشجویی پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- استفاده از بهینه سازی ذرات هیبرید در آموزش شبکه عصبی فیدبک

- پایان نامه در مورد پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- تحقیق درباره پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- مقاله دانشجویی پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی در قالب پاياننامه

- پروپوزال در مورد پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- گزارش سمینار در مورد پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی

- گزارش کارورزی درباره پرورش شبکه های عصبی پیشخور (FNN ها) توسط بهینه سازی ازدحام ذرات (PSO) هیبرید و الگوریتم جستجوی گرانشی