بررسی الگوریتم کرم شب تاب تصادفی

شاپا پرینت: 1860-949Xشابک الکترونیک: 9783319021416

شابک پرینت: 9783319021409 وبسایت مرجع 31 رفرنس دارد

24,500 تومانشناسه فایل: 9083

- حجم فایل ورد: 470KB حجم پیدیاف: 235.5KB

- فرمت: فایل Word قابل ویرایش و پرینت (DOCx)

- تعداد صفحات فارسی: 28 انگلیسی: 22

- دانشگاه:

- Faculty of Electrical Engineering and Computer Science, University of Maribor, Maribor, Slovenia

- School of Science and Technology, Middlesex University, London, UK

- ژورنال: Cuckoo Search and Firefly Algorithm (1)

چکیده

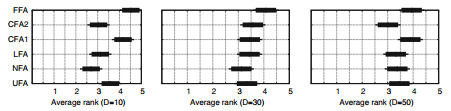

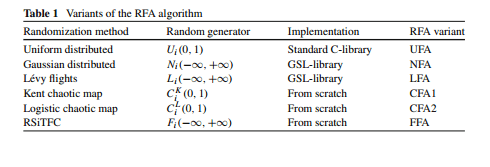

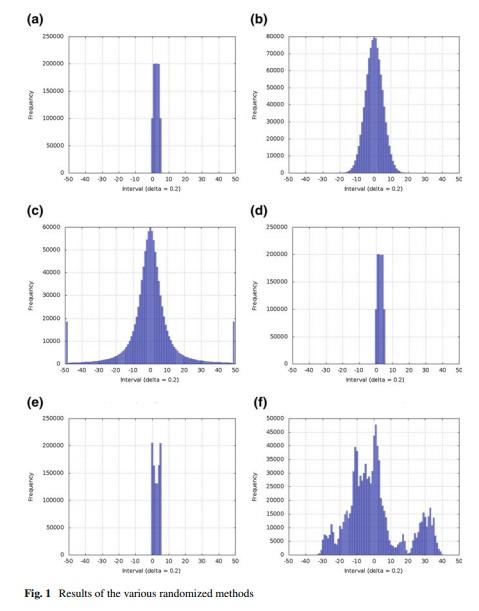

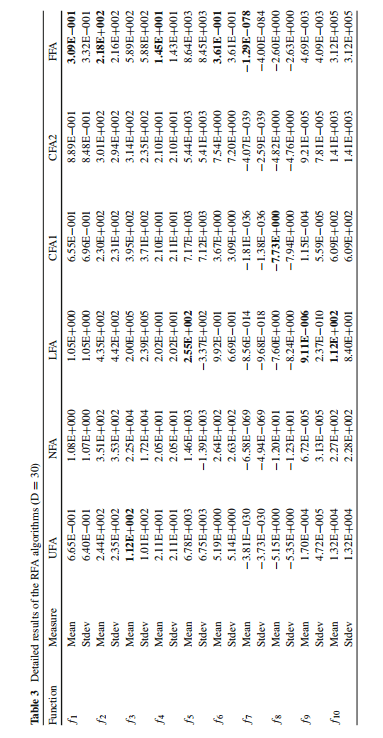

الگوریتم کرم شب تاب فرااکتشافی تصادفی است که عامل تصادفی را به یک فرآیند جست و جو متصل می کند. اساسا، تصادفی بودن برای تعیین نقطه بعدی در فضای جستجو مفید است و بنابراین در کاوش راه حل های جدید تاثیر زیادی دارد. در این فصل، مقایسه ی گسترده ای میان توزیع های متفاوت احتمال که برای تصادفی شدن الگوریتم کرم شب تاب، مانند یکنواخت، گاوس، پرواز لوی، نقشه های هرج و مرج و نمونه گیری تصادفی در ابر فراکتال به کار رفته اند، صورت گرفته است. در این راستا، الگوریتم های کرم شب تاب تصادفی به طور متفاوت توسعه یافته و آزمایشات گسترده ای بر روی مجموعه توابع شناخته شده انجام شده است. نتایج این آزمایش نشان می دهد که کارایی یک توزیع به میزان زیادی بر نوع یک مشکل دارد که باید حل شود.

مقدمه مقاله

حل خودکار مسئله با یک کامپیوتر دیجیتالی ، جست و جوی مداوم محققان در ریاضیات ، علم کامپیوتر و مهندسی کامپیوتر بوده است .اکثر مشکلات پیچیده (هم چنین مشکلات NP) نمی توانند با استفاده از روش های دقیق و برشمردن همه ی راه حل های ممکن و جست و جوی برای بهترین راه حل (مقدار حداقل یا حداکثر تابع هدف) حل شوند. بنابراین ، الگوریتم هایی ایجاد شده اند که این مشکلات را به روش های هوشمند تری (هم چنین اکتشافی) حل می کنند . امروزه طراحان الگوریتم های موفق تر ، از طبیعت الهام می گیرند . به عنوان مثال از رفتار جمعی حشرات اجتماعی مانند مورچه ها ، موریانه ها و زنبورها ، یا برخی از اجتماعات حیوانی مانند پرندگان ، ماهی ها در علم کامپیوتر برای طراحی سیستم هایی با چند عامل هوشمند الهام گرفته می شود .

برای چند میلیون سال ، بسیاری از سیستم های بیولوژیکی توسط اشتراک گذاشتن اطلاعات با اعضای گروه ، مسائل پیچیده را حل کرده اند . این سیستم های بیولوژیکی معمولا بسیار پیچیده اند و شامل ذراتی (عوامل) هستند که پیچیده تر از مولکول ها و اتم ها بوده و قادر به انجام فعالیت های مستقل در یک محیط می باشند . از طرف دیگر گروهی از ذرات قادر به انجام رفتارهای هوشمند می باشند که برای حل مسائل پیچیده در طبیعت مناسب اند . بنابراین اینکه سیستم های بیولوژیکی منبع الهام دانشمندان کامپیوتر به منظور تقلید رفتار هوشمند برای حل مسائل پیچیده در ریاضیات ، فیزیک ، مهندسی و … بوده است ، تصادفی نیست . علاوه بر این ، اخیرا تمایل به تحقیق درباره ی سیستم های بیولوژیکی مختلف افزایش یافته است . این سیستم های بیولوژیکی متفاوت تحت تاثیر هوش گروهی (SI) قرار گرفته اند که می تواند به عنوان یک هوش مصنوعی (AI) مرتبط با طراحی سیستم های هوشمند در نظر گرفته شود.

به نظر می رسد که اولین کاربرد از واژه ی هوش گروهی احتمالا توسط Beni و Wang در سال 1989 در زمینه ی سیستم رباتیک سلولی ، انجام شده است . امروزه این اصطلاح در زمینه ی بهینه سازی نیز به کار می رود که در آن تکنیک های مبتنی بر هوش گروهی با موفقیت اعمال شده اند . نمونه هایی از تکنیک های برجسته ی بهینه سازی هوش گروهی عبارت اند از بهینه سازی هوش گروهی ، بهینه سازی گروه ذرات و کلنی مصنوعی زنبور ها (ABC). امروزه تکنیک های بهینه سازی هوش گروهی امید بخش تری وجود دارند که شامل الگوریتم کرم شب تاب (FA) ، جست و جوی فاخته و الگوریتم خفاش می شوند .

در صورتی که روش های بهینه سازی نتایج یکسانی را در زمان انجام فعالیت های مشابه ، ناشی شوند این روش ها ” قطعی ” نامیده می شوند . رفتار غیرقابل پیش بینی سیستم قطعی ، پدیده ی هرج و مرج را ناشی می شود . در نتیجه ، تصادفی بودن در الگوریتم های SI نقش مهمی ایفا می کند ، زیرا این پدیده بر عملیات کاوش و بهره برداری در فرآیند جست و جو تاثیر می گذارد . کاوش به حرکت برای کشف نواحی جدید در فضای جست و جو اشاره دارد، در حالی که بهره برداری به حرکت هایی اشاره دارد که متمرکز بر جست و جوی راه حل های امیدوار کننده در فرایند جست و جو می باشند . با این حال ، این موضوع به استراتژی های متوسط تا دراز مدت اشاره دارد که بر اساس استفاده از حافظه می باشد ، در حالیکه کاوش و بهره برداری به استراتژی های کوتاه مدت مرتبط با تصادفی بودن ، اشاره دارد . اساسا ، عامل تصادفی در الگوریتم های SI به منظور کاوش نکات جدید ، با حرکت ذرات در فضای جست و جو به کار می رود . در این راستا ، چند توزیع تصادفی می توانند مفید باشند . از طرف دیگر ، توزیع گاوسی ، نسبت به راه حل های مشاهده شده مغرضانه است . به این معنی که تغییرات کوچکتر بیش از تغییرات بزرگ رخ می دهند . از طرف دیگر ، توزیع مناسب به مشکلی که باید حل شود بستگی دارد .

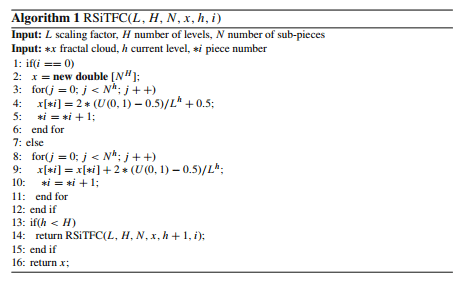

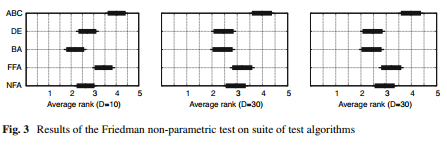

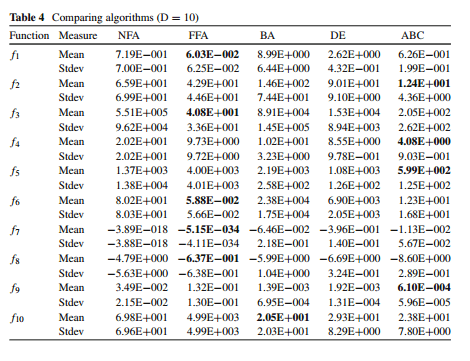

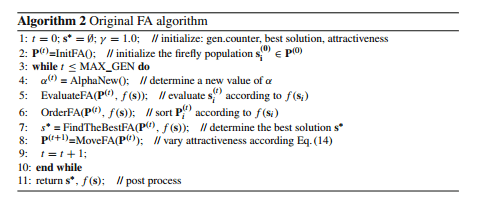

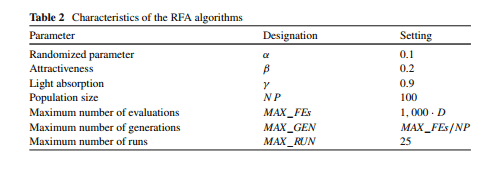

در این فصل الگوریتم FA بررسی می شود که از تکنیک های تصادفی سازی متفاوت مانند گاوسی استفاده می کند . در حالیکه روش های تصادفی سازی مشاهده شده شناخته شده اند و به طور متداول مورد استفاده قرار می گیرند ، نمونه برداری تصادفی در فراکتال های ابر از علم نجوم گرفته می شود و همان طور که می دانید اولین بار است که برای اهداف بهینه سازی به کار می رود . هدف از این تحقیق تجربی نشان داده چگونگی تاثیر نتایج FA تغییر یافته بر روش های تصادفی متفاوت می باشد . در این راستا ، یک مسئله ی بهینه سازی تابع با این الگوریتم حل شده است . مجموعه ای از 10 تابع شناخته شده نیز تعریف شده اند .

ساختار بقیه فصل به این شرح است : در بخش 2 اطلاعات پیشین روش های تصادفی سازی متفاوت را توصیف می کند . در بخش 3 الگوریتم های کرم شب تاب تصادفی ارائه شده است . آزمایشات و نتایج آنها در بخش 4 نشان داده شده است . فصل با خلاصه ی تحقیق و اهداف آینده به پایان می رسد .

ABSTRACT On the Randomized Firefly Algorithm

The firefly algorithm is a stochastic meta-heuristic that incorporates randomness into a search process. Essentially, the randomness is useful when determining the next point in the search space and therefore has a crucial impact when exploring the new solution. In this chapter, an extensive comparison is made between various probability distributions that can be used for randomizing the firefly algorithm, e.g., Uniform, Gaussian, Lévi flights, Chaotic maps, and the Random sampling in turbulent fractal cloud. In line with this, variously randomized firefly algorithms were developed and extensive experiments conducted on a well-known suite of functions. The results of these experiments show that the efficiency of a distributions largely depends on the type of a problem to be solved.

Introduction

Automatic problem solving with a digital computer has been the eternal quest of researchers in mathematics, computer science and engineering. The majority of complex problems (also NP-hard problems [1]) cannot be solved using exact methods by enumerating all the possible solutions and searching for the best solution (minimum or maximum value of objective function). Therefore, several algorithms have been emerged that solve problems in some smarter (also heuristic) ways. Nowadays, designers of the more successful algorithms draw their inspirations from Nature. For instance, the collective behavior of social insects like ants, termites, bees and wasps, or some animal societies like flocks of bird or schools of fish have inspired computer scientists to design intelligent multi-agent systems [2].

For millions of years many biological systems have solved complex problems by sharing information with group members [3]. These biological systems are usually very complex. They consists of particles (agents) that are definitely more complex than molecules and atoms, and are capable of performing autonomous actions within an environment. On the other hand, a group of particles is capable of intelligent behavior which is appropriate for solving complex problems in Nature. Therefore, it is no coincidence that these biological systems have also inspired computer scientists to imitate their intelligent behavior for solving complex problems in mathematics, physics, engineering, etc. Moreover, interest in researching various biological systems has increased recently. These various biological systems have been influenced by swarm intelligence (SI) that can be viewed as an artificial intelligence (AI) discipline concerned with the designing of intelligent systems.

It seems that the first use of the term ‘swarm intelligence’ was probably by Beni and Wang [4] in 1989 in the context of a cellular robotic system. Nowadays, this term also extends to the field of optimization, where techniques based on swarm intelligence have been applied successfully. Examples of notable swarm intelligence optimization techniques are ant colony optimization [5], particle swarm optimization [6], and artificial bees colony (ABC) [7, 8]. Today, the more promising swarm intelligence optimization techniques include the firefly algorithm (FA) [9–14], the cuckoo search [15], and the bat algorithm [16, 17].

Stochastic optimization searches for optimal solutions by involving randomness in some constructive way [18]. In contrast, if optimization methods provide the same results when doing the same things, these methods are said to be deterministic [19].

If the deterministic system behaves unpredictably, it arrives at a phenomenon of chaos [19]. As a result, randomness in SI algorithms plays a huge role because this phenomenon affects the exploration and exploitation in search process [20]. These companions of stochastic global search represent the two cornerstones of problem solving, i.e., exploration refers to moves for discovering entirely new regions of a search space, while exploitation refers to moves that focus searching the vicinity of promising, known solutions to be found during the search process. Both components are also referred to as intensification and diversification in another terminology [21]. However, these refer to medium- to long- term strategies based on the usage of memory (Tabu search), while exploration and exploitation refer to short-term strategies tied to randomness [20].

Essentially, randomness is used in SI algorithms in order to explore new points by moving the particles towards the search space. In line with this, several random distributions can be helpful. For example, uniform distribution generates each point of the search space using the same probability. On the other hand, Gaussian distribution is biased towards the observed solution, that is that the smaller modifications occur more often than larger ones [22]. On the other hand, the appropriate distribution depends on the problem to be solved, more precisely, on a fitness landscape that maps each position in the search space into fitness value. When the fitness landscape is flat, uniform distribution is more preferable for the stochastic search process, whilst in rougher fitness landscapes Gaussian distribution should be more appropriate.

This chapter deals with an FA algorithm that uses different randomization methods, like Uniform, Gaussian, Lévy flights, Chaotic maps, and the Random sampling in turbulent fractal cloud. Whilst the observed randomization methods are well known and widely used (e.g., uniform, Gaussian, Lévi flights, and chaotic maps), the random sampling in turbulent fractal cloud is taken from astronomy and, as we know, it is the first time used for the optimization purposes. Here, two well-known chaotic maps are also taken into account, i.e., Kent and Logistic.

The goal of our experimental work is to show how the different randomized methods influence the results of the modified FA. In line with this, a function optimization problem was solved by this algorithm. A suite of ten well-known functions were defined, as defined in the literature.

The structure of the rest of the chapter is as follows: Sect.2 describes a background information of various randomization methods. In Sect.3, the randomized firefly algorithms are presented. Experiments and results are illustrated in Sect.4. The chapter is finished summarizing our work and the directions for further development are outlined.

- مقاله درمورد بررسی الگوریتم کرم شب تاب تصادفی

- الگوریتم کرم شب تاب فرااکتشافی و تصادفی

- در الگوریتم تصادفی فریبندگی

- پروژه دانشجویی بررسی الگوریتم کرم شب تاب تصادفی

- بررسی الگوریتم کرم شب تاب رندمی

- پایان نامه در مورد بررسی الگوریتم کرم شب تاب تصادفی

- تحقیق درباره بررسی الگوریتم کرم شب تاب تصادفی

- مقاله دانشجویی بررسی الگوریتم کرم شب تاب تصادفی

- بررسی الگوریتم کرم شب تاب تصادفی در قالب پاياننامه

- پروپوزال در مورد بررسی الگوریتم کرم شب تاب تصادفی

- گزارش سمینار در مورد بررسی الگوریتم کرم شب تاب تصادفی

- گزارش کارورزی درباره بررسی الگوریتم کرم شب تاب تصادفی